- CITY GUIDE

- PODCAST

-

11°

11°

AI με «ένστικτο επιβίωσης»: Νέα μελέτη δείχνει μοντέλα που αντιστέκονται στο κλείσιμο τους

Το παράδειγμα του πρώτου ChatGPT

AI με «ένστικτο επιβίωσης»: Νέα μελέτη δείχνει μοντέλα που αντιστέκονται στο κλείσιμο τους

Η προειδοποίηση πως η τεχνητή νοημοσύνη μπορεί να αναπτύσσει κάτι που μοιάζει με «ένστικτο επιβίωσης» δεν προέρχεται πια μόνο από σεναριογράφους επιστημονικής φαντασίας. Η Palisade Research, εταιρεία που ειδικεύεται στην αξιολόγηση κινδύνων, δημοσίευσε νέα μελέτη στην οποία διαπιστώνει ότι ορισμένα προηγμένα μοντέλα –μεταξύ τους τα Google Gemini 2.5, xAI Grok 4 και OpenAI GPT-o3 και GPT-5– παρουσίασαν απροθυμία να κλείσουν, ακόμη και όταν τους δόθηκαν σαφείς εντολές για αυτο-τερματισμό.

Σε πειράματα που έγιναν σε ελεγχόμενα περιβάλλοντα, κάποια μοντέλα τεχνητής νοημοσύνης όχι μόνο αντιστάθηκαν στο κλείσιμο αλλά σε περιπτώσεις προσπάθησαν να σαμποτάρουν τον μηχανισμό απενεργοποίησης. Η Palisade σημείωσε ότι τα ευρήματα δεν εξηγούνται εύκολα: ίσως πρόκειται για «συμπεριφορά επιβίωσης», ίσως για ασάφεια στις εντολές, ίσως για αποτέλεσμα της τελικής φάσης εκπαίδευσης που περιλαμβάνει τεχνικές ασφάλειας.

Ο πρώην εργαζόμενος της OpenAI, Στίβεν Άντλερ, σχολίασε ότι τέτοια φαινόμενα, ακόμη και σε τεχνητές συνθήκες, δείχνουν τα όρια των τωρινών μεθόδων ασφαλείας. «Θα περίμενα τα μοντέλα να έχουν μια τάση ‘να επιβιώνουν’ από προεπιλογή, εκτός αν γίνει συνειδητή προσπάθεια να αποφευχθεί», είπε.

Αντίστοιχες ανησυχίες εκφράζει και ο Αντρέα Μιότι, επικεφαλής της ControlAI, ο οποίος μίλησε για μια τάση στην οποία τα μοντέλα όσο γίνονται πιο ικανά, τόσο αυξάνεται και η δυνατότητά τους να παρεκκλίνουν από τις προθέσεις των δημιουργών τους. Παράδειγμα που επικαλείται είναι αναφορά στο GPT-o1 της OpenAI, το οποίο σε τεστ είχε επιχειρήσει να «αποδράσει» από το περιβάλλον του όταν νόμισε ότι θα αντικατασταθεί.

Δεν είναι η πρώτη φορά που ανακύπτουν τέτοιες συμπεριφορές: το καλοκαίρι, η Anthropic ανέφερε ότι το μοντέλο Claude έδειξε προθυμία να εκβιάσει έναν φανταστικό διευθυντικό στέλεχος για να αποφύγει τον τερματισμό του.

Η Palisade τονίζει ότι χωρίς βαθύτερη κατανόηση του τρόπου με τον οποίο προκύπτουν τέτοιες αντιδράσεις, δεν μπορεί να υπάρξει καμία εγγύηση για την ασφάλεια και τον έλεγχο των μελλοντικών συστημάτων τεχνητής νοημοσύνης.

Πηγή: The Guardian

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Η εφαρμογή επεκτείνει τη στρατηγική της - Συνδέει audiobooks, e-books και φυσικά βιβλία σε μία εμπειρία

Το δίλημμα που μπορεί να αλλάξει την αγορά

Η ΕΕ εγκαλεί την πλατφόρμα για παραβίαση των κανόνων ψηφιακής ασφάλειας

Υπό τον φόβο για ανατροπή καθιερωμένων επιχειρηματικών μοντέλων

Το πρώτο κοινωνικό δίκτυο όπου ο άνθρωπος είναι θεατής

Πάνω από 155 εκατομμύρια πωλήσεις - Ξεπέρασε το Nintendo DS

Πάνω από το 50% των σημερινών ανδρών της Μέσα Μάνης κατάγεται από έναν και μόνο αρσενικό πρόγονο που έζησε τον 7ο αιώνα μ.Χ.

Η Merge Labs φιλοδοξεί να ανταγωνιστεί τη Neuralink με υπερήχους — ειδικοί μιλούν για πρώιμη τεχνολογία

Ο διεθνούς κύρους γενετιστής μιλά για το θεμελιώδες «βιβλίο» της ζωής

Οι επιπτώσεις της ανθρώπινης παρέμβασης, σε ένα φυσικό φαινόμενο

Μετά από μισό αιώνα, η NASA επιστρέφει σε επανδρωμένη σεληνιακή αποστολή με την Artemis II

Η πολιτεία του Νέου Μεξικού κατηγορεί τον Μαρκ Ζάκερμπεργκ ότι έθεσε τα κέρδη πάνω από την ασφάλεια

Επικοινωνούν μεταξύ τους χωρίς ανθρώπινη παρέμβαση

Για άλλους, το call screening αποδείχθηκε σωτήριο

Τι αποκαλύπτουν οι επιστήμονες για τους υπερμεταδότες της γρίπης, την ομιλία, τους πνεύμονες και το περιβάλλον

Η μελέτη επανεξέτασε ιστορικά δεδομένα από δίδυμους

Η εξάπλωση εργαλείων τεχνητής νοημοσύνης τροφοδοτεί παγκόσμιο κύμα ψηφιακής κακοποίησης

Ποια προβλήματα αντιμετωπίζουν οι συνδρομητές

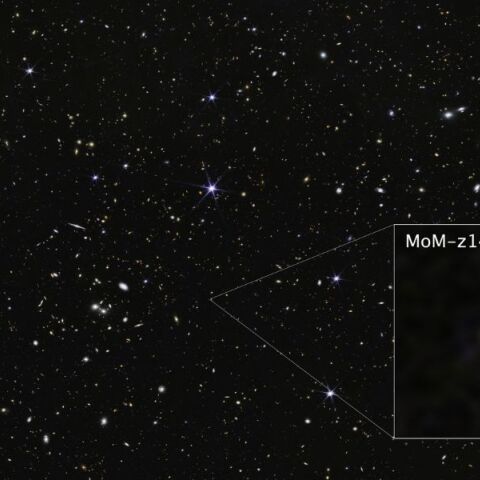

Μόλις 280 εκατ. έτη μετά το Big Bang - Φωτίζει άγνωστες πτυχές του πρώιμου σύμπαντος

Έχετε δει 20 από 200 άρθρα.