- CITY GUIDE

- PODCAST

-

11°

11°

Η Google έκλεισε το λογαριασμό ενός χρήστη γιατί θεώρησε CSAM ιατρικές φωτογραφίες

Τι ακριβώς συνέβη και γιατί δεν δέχεται να επαναφέρει τον λογαριασμό του

Η Google αρνείται να αποκαταστήσει το λογαριασμό ενός άνδρα που τράβηξε ιατρικές εικόνες από τη βουβωνική χώρα του γιου του.

Η Google αρνήθηκε να αποκαταστήσει το λογαριασμό ενός άνδρα, αφού προηγουμένως είχε λανθασμένα χαρακτηρίσει μερικές ιατρικές εικόνες που τράβηξε από τη βουβωνική χώρα του γιου του ως υλικό σεξουαλικής κακοποίησης παιδιών (CSAM), όπως ανέφεραν πρώτοι οι New York Times. Οι ειδικοί λένε ότι πρόκειται για μια αναπόφευκτη παγίδα της προσπάθειας εφαρμογής μιας τεχνολογικής λύσης σε ένα κοινωνικό πρόβλημα.

Οι ειδικοί έχουν από καιρό προειδοποιήσει για τους περιορισμούς των αυτοματοποιημένων συστημάτων ανίχνευσης εικόνων σεξουαλικής κακοποίησης παιδιών, ιδίως καθώς οι εταιρείες αντιμετωπίζουν ρυθμιστικές και δημόσιες πιέσεις για να συμβάλουν στην αντιμετώπιση της ύπαρξης υλικού σεξουαλικής κακοποίησης.

«Αυτές οι εταιρείες έχουν πρόσβαση σε έναν τρομερά επεμβατικό όγκο δεδομένων σχετικά με τη ζωή των ανθρώπων. Και παρ' όλα αυτά δεν έχουν το πλαίσιο της πραγματικής ζωής των ανθρώπων», δήλωσε ο Daniel Kahn Gillmor, ανώτερος τεχνολόγος στο ACLU. «Υπάρχουν όλων των ειδών τα πράγματα όπου απλώς το γεγονός της ζωής σας δεν είναι τόσο ευανάγνωστο σε αυτούς τους γίγαντες της πληροφορίας». Πρόσθεσε ότι η χρήση αυτών των συστημάτων από τεχνολογικές εταιρείες που «λειτουργούν ως πληρεξούσιοι» για την επιβολή του νόμου θέτει τους ανθρώπους σε κίνδυνο να «παρασυρθούν από τη δύναμη του κράτους».

Ο άντρας, που αναγνωρίστηκε μόνο ως Μαρκ από τους New York Times, τράβηξε φωτογραφίες της βουβωνικής χώρας του γιου του για να τις στείλει σε γιατρό, αφού συνειδητοποίησε ότι είχε φλεγμονή. Ο γιατρός χρησιμοποίησε αυτή την εικόνα για να διαγνώσει τον γιο του Μαρκ και να του συνταγογραφήσει αντιβιοτικά. Όταν οι φωτογραφίες μεταφορτώθηκαν αυτόματα στο cloud, το σύστημα της Google τις αναγνώρισε ως CSAM. Δύο ημέρες αργότερα, το Gmail του Μαρκ και άλλοι λογαριασμοί Google, συμπεριλαμβανομένου του Google Fi, που παρέχει την τηλεφωνική του υπηρεσία, απενεργοποιήθηκαν λόγω «επιβλαβούς περιεχομένου» που αποτελούσε «σοβαρή παραβίαση των πολιτικών της εταιρείας και μπορεί να είναι παράνομο», ανέφεραν οι Times, επικαλούμενοι ένα μήνυμα στο τηλέφωνό του. Αργότερα ανακάλυψε ότι η Google είχε επισημάνει ένα άλλο βίντεο που είχε στο τηλέφωνό του και ότι το αστυνομικό τμήμα του Σαν Φρανσίσκο ξεκίνησε έρευνα εναντίον του.

Ο Μαρκ απαλλάχθηκε από κάθε ποινικό αδίκημα, αλλά η Google δήλωσε ότι θα επιμείνει στην απόφασή της.

«Ακολουθούμε τη νομοθεσία των ΗΠΑ για να ορίσουμε τι συνιστά CSAM και χρησιμοποιούμε έναν συνδυασμό τεχνολογίας αντιστοίχισης hash και τεχνητής νοημοσύνης για να το εντοπίσουμε και να το αφαιρέσουμε από τις πλατφόρμες μας», δήλωσε η Christa Muldoon, εκπρόσωπος της Google.

Η Muldoon πρόσθεσε ότι οι υπάλληλοι της Google που εξετάζουν το CSAM εκπαιδεύτηκαν από ειδικούς ιατρούς για να αναζητούν εξανθήματα ή άλλα ζητήματα. Οι ίδιοι, ωστόσο, δεν ήταν ειδικοί σε θέματα ιατρικής και δεν ζητήθηκε η γνώμη ιατρικών εμπειρογνωμόνων κατά την εξέταση της κάθε περίπτωσης, δήλωσε η ίδια.

Αυτός είναι ένας μόνο τρόπος με τον οποίο αυτά τα συστήματα μπορούν να προκαλέσουν βλάβη, σύμφωνα με την Gillmor. Για την αντιμετώπιση, για παράδειγμα, τυχόν περιορισμών που μπορεί να έχουν οι αλγόριθμοι στη διάκριση μεταξύ επιβλαβών εικόνων σεξουαλικής κακοποίησης και ιατρικών εικόνων, οι εταιρείες συχνά έχουν έναν άνθρωπο στο βρόχο. Όμως και οι ίδιοι οι άνθρωποι είναι εγγενώς περιορισμένοι ως προς την τεχνογνωσία τους, και για να βρεθεί το κατάλληλο πλαίσιο για κάθε περίπτωση απαιτείται περαιτέρω πρόσβαση στα δεδομένα των χρηστών. Η Gillmor δήλωσε ότι πρόκειται για μια πολύ πιο παρεμβατική διαδικασία που θα μπορούσε να εξακολουθεί να είναι μια αναποτελεσματική μέθοδος εντοπισμού CSAM.

«Αυτά τα συστήματα μπορούν να προκαλέσουν πραγματικά προβλήματα στους ανθρώπους», δήλωσε. «Και δεν είναι μόνο ότι δεν πιστεύω ότι αυτά τα συστήματα μπορούν να πιάσουν κάθε περίπτωση παιδικής κακοποίησης, είναι ότι έχουν πραγματικά τρομερές συνέπειες όσον αφορά τα ψευδώς θετικά αποτελέσματα για τους ανθρώπους. Οι ζωές των ανθρώπων μπορούν πραγματικά να ανατραπούν από τα μηχανήματα και τους ανθρώπους στο κύκλωμα που απλά παίρνουν μια κακή απόφαση, επειδή δεν έχουν κανένα λόγο να προσπαθήσουν να το διορθώσουν».

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Τα τεχνικά προβλήματα όσον αφορά τη σύνδεση και παραμονή στα εν λόγω μέσα κοινωνικής δικτύωσης, παρατηρούνται μάλιστα και στην Ελλάδα.

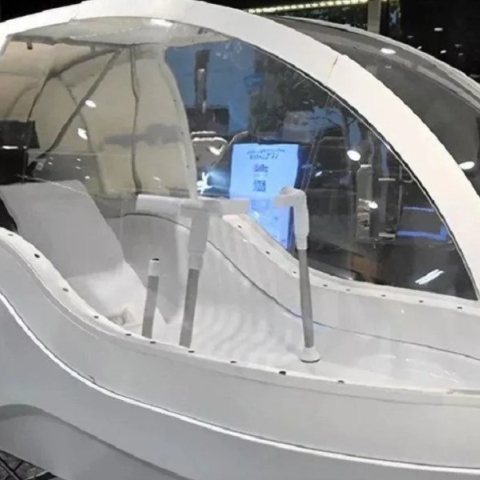

Το design και οι επιδόσεις του μέλλοντος στο σήμερα

Από τη θεραπεία αυτοάνοσων νοσημάτων με Τ-κύτταρα μέχρι δείγματα χώματος από τη Σελήνη

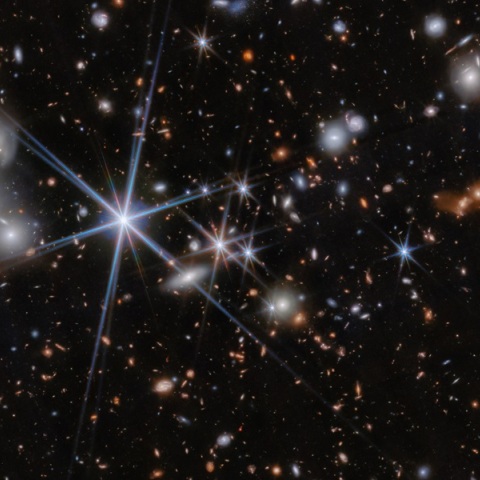

Οι επιστήμονες το 1998 αποκάλυψαν ότι αυτή η διαστολή επιταχύνεται, με την υποτιθέμενη αιτία να είναι η σκοτεινή ενέργεια

Τα αποτελέσματα που ανακοινώθηκαν τη Δευτέρα προήλθαν από ένα νέο τσιπ που ονομάζεται Willow

Πάνω από 15 εκατομμύρια διαδικτυακές απειλές το 2024 - Ανάγκη για ενισχυμένα μέτρα προστασίας

Τα ευρήματα μεγάλης έρευνας

Είναι τόσο μεγάλο κομμάτι της ζωής μας πια, που όταν δεν υπάρχει σύνδεση, κάτι μας πιάνει…

Όψεις της πόλης, αναμνήσεις, πράγματα που συνέβησαν παλιά, και πράγματα που συμβαίνουν σήμερα γύρω μας

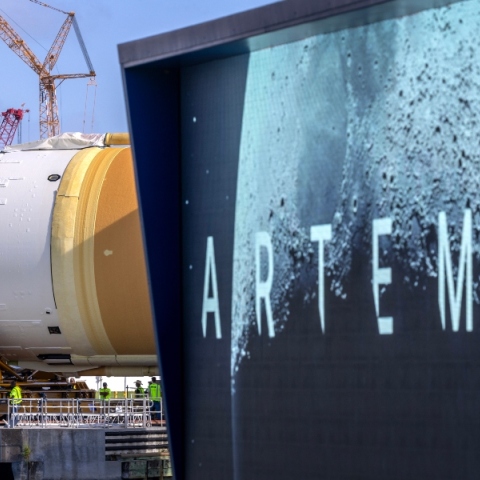

Θα αργήσει η επιστροφή των ΗΠΑ στη Σελήνη

Η υπηρεσία λειτουργεί επί του παρόντος σε μερικές τοποθεσίες στις ΗΠΑ, στο Τέξας και την Αριζόνα

«Τα παιδιά χάνουν τον προσανατολισμό τους, ασχολούνται μόνο με likes»

Διαφορετική εικόνα από εκείνη που επικράτησε στις αγιογραφίες

Πόσο θα επηρεαστεί το οικοσύστημα και το κλίμα της Γης

Σε όλο τον κόσμο γίνονται προσπάθειες για την ανάπτυξη ανθεκτικών καλλιεργειών

Μερικά από τα πιο εμβληματικά και αγαπημένα παιχνίδια πρωταγωνιστούν στο επετειακό clip

Μια επένδυση που ξεπερνά τα 10 δισεκατομμύρια δολάρια

Χρειάζεται μόλις 15 λεπτά για να εκτελέσει έναν πλήρη κύκλο ανθρώπινης πλύσης

«Εξαιρετικά ανεπαρκής ο έλεγχος - Επιλέγει να μην τον εφαρμόσει»

Η τεχνολογία είναι πολύ σημαντικό θέμα για να το αφήσουμε απλώς στους τεχνολόγους

Έχετε δει 20 από 200 άρθρα.