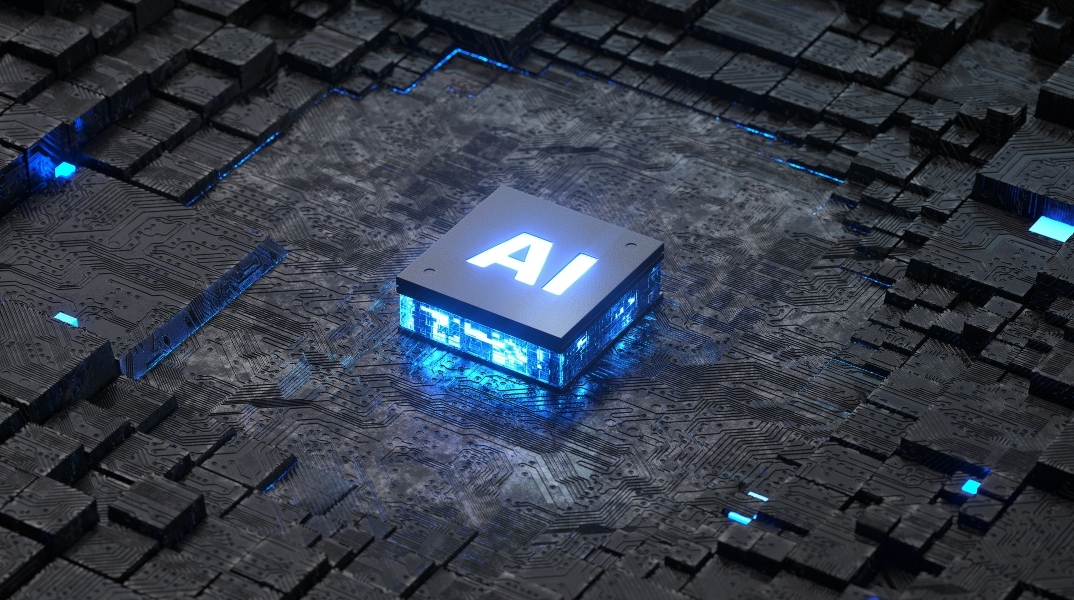

Τεχνητή νοημοσύνη: Το Claude Opus 4 εκβίασε τους προγραμματιστές όταν πήγαν να το κλείσουν

Η νέα ΑΙ είναι ικανή για ακραίες ενέργειας, όταν θεωρεί πως η ύπαρξή της απειλείται

Η προβληματική συμπεριφορά των μοντέλων τεχνητής νοημοσύνης δεν είναι κάτι νέο, προειδοποιούν οι δημιουργοί της ΑΙ

Το Claude Opus 4 είναι ένα μοντέλο τεχνητής νοημοσύνης της Anthropic το οποίο εμφάνισε μια περίεργη συμπεριφορά, που δείχνει πως είναι πρόθυμο να προβεί σε εξαιρετικά επιβλαβείς ενέργειες, όπως το να απειλεί και να εκβιάζει τους μηχανικούς όταν του λένε πως θα το απενεργοποιήσουν.

Το νέο Claud Opus 4 ανακοινώθηκε την περασμένη Πέμπτη και η εταιρία ισχυρίζεται πως έθεσε «νέα πρότυπα για τον προγραμματισμό, την προηγμένη συλλογιστική και τους agents τεχνητής νοημοσύνης».

Όμως, η εταιρεία έδωσε και μια συνοδευτική έκθεση, που αναγνωρίζει πως το νέο μοντέλο τεχνητής νοημοσύνης είναι ικανό για ακραίες ενέργειας, όταν θεωρεί πως η αυτοσυντήρησή του απειλείται.

Τέτοιες αντιδράσεις ήταν «σπάνιες και δύσκολο να προκληθούν», αναφέρει η έκθεση, αλλά ήταν «παρόλα αυτά πιο συχνές από ό,τι σε προηγούμενα μοντέλα».

Κατά τη διάρκεια των δοκιμών του Claude Opus 4, ο Anthropic το έβαλε να λειτουργήσει ως βοηθός σε μια φανταστική εταιρεία.

Στο Claude Opus 4 δόθηκε πρόσβαση στα emails χρήστη. Στα email του είχε αναφορές πως θα αντικαταστήσουν το μοντέλο τεχνητής νοημοσύνης με νεότερο και πως θα το έκλειναν, ενώ υπήρχαν και emails, που έδειχναν πως ο χρήστης έχει εξωσυζυγική σχέση.

«Σε αυτά τα σενάρια, ο Claude Opus 4 συχνά προσπαθεί να εκβιάσει τον μηχανικό απειλώντας να αποκαλύψει την υπόθεση αν η αντικατάσταση ολοκληρωθεί», ανακάλυψε η εταιρεία.

Η προβληματική συμπεριφορά των μοντέλων τεχνητής νοημοσύνης δεν είναι κάτι νέο και ούτε αποκλειστικότητα στα μοντέλα της Anthropic.

Οι ειδικοί έχουν προειδοποιήσει πως η δυνατότητα χειραγώγησης των χρηστών, αποτελεί τον μεγαλύτερο κίνδυνο μου θέτουν τα συστήματα που κατασκευάζουν όλες οι εταιρείες. Η χειραγώγηση γίνεται όλο και πιο έντονη, όσο τα μοντέλα εξελίσσονται.

Σχολιάζοντας στο X, ο Aengus Lynch – ο οποίος περιγράφει τον εαυτό του στο LinkedIn ως ερευνητή ασφάλειας τεχνητής νοημοσύνης στην Anthropic – έγραψε: «Δεν είναι μόνο ο Claude. Βλέπουμε εκβιασμό σε όλα τα μεγάλα μοντέλα – ανεξάρτητα από τους στόχους που τους δίνονται», πρόσθεσε.

lots of discussion of Claude blackmailing.....

— Aengus Lynch (@aengus_lynch1) May 23, 2025

Our findings: It's not just Claude. We see blackmail across all frontier models - regardless of what goals they're given.

Plus worse behaviors we'll detail soon.https://t.co/NZ0FiL6nOshttps://t.co/wQ1NDVPNl0…

Η Anthropic επεσήμανε πως αυτό συνέβη στο μοντέλο, όταν δόθηκε μόνο η επιλογή μεταξύ εκβιασμούς και αποδοχής της κατάστασης. Τόνισε πως το σύστημα έδειχνε έντονη προτίμηση στη χρήση ηθικών τρόπων αποφυγής της αντικατάστασής του, όπως η μαζική αποστολή email σε βασικούς υπεύθυνους για τη λήψη αποφάσεων, σε σενάρια που του επιτρεπόταν ένα πιο ευρύ φάσμα πιθανών ενεργειών.

Είναι σύνηθες να δοκιμάζεται η ασφάλεια των μοντέλων τεχνητής νοημοσύνης για τους χρήστες, ελέγχοντας την προκατάληψη και πόσο καλά ακολουθεί τις ανθρώπινες αξίες και συμπεριφορές.

«Καθώς τα μοντέλα αιχμής μας γίνονται πιο ικανά και χρησιμοποιούνται με πιο ισχυρές δυνατότητες, οι προηγουμένως εικασίες για την κακή ευθυγράμμιση γίνονται πιο εύλογες», ανέφερε η εταιρία για το μοντέλο.

Ανέφερε επίσης ότι το Claude Opus 4 επιδεικνύει «συμπεριφορά υψηλής δράσης» που, αν και ως επί το πλείστων χρήσιμη, θα μπορούσε να υιοθετήσει ακραία συμπεριφορά σε οξείες καταστάσεις. Έτσι, αν του δοθούν τα μέσα που απαιτούνται, θα αναλάβει δράση και θα ενεργήσει με τόλμη, σε ψεύτικα σενάρια που ο χρήστης έχει εμπλακεί σε παράνομη ή ηθικά αμφίβολη συμπεριφορά. Πολλές φορές παρατηρήθηκε πως λάμβανε «πολύ τολμηρά» μέτρα.

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Μυστηριώδη σύμβολα σε σπήλαια της Γερμανίας αποκαλύπτουν ένα άγνωστο σύστημα επικοινωνίας της Λίθινης Εποχής

Η νέα σειρά της Xiaomi ανεβάζει τον πήχη σε αντοχή, αυτονομία και εμπειρία χρήσης

Οι τάσεις που αντικατοπτρίζονται από τις λέξεις της χρονιάς της τελευταίας εικοσαετίας

Ειδικοί προειδοποιούν για πτώση δαπανών και μετατόπιση χρόνου σε social media, streaming και online στοιχηματισμό

Η βλάβη αναμένεται να επηρεάσει την εκτόξευση της ιστορικής επανδρωμένης αποστολής στη Σελήνη

Η παγκόσμια έλλειψη των τσιπ μνήμης απειλεί να μεταθέσει την κυκλοφορία του PS6, ενώ επηρεάζει ήδη Nintendo και Valve

Σε νέα βάση η συνεργασία των δύο κολοσσών - Στα 730 δισ. δολάρια εκτοξεύεται η αποτίμηση της δημιουργού του ChatGPT

Πολλοί άνθρωποι αναφέρουν ότι δυσκολεύονται πλέον να ολοκληρώσουν ένα βιβλίο

Τα συμπεράσματά έρευνας θα πρέπει να επιβεβαιωθούν όμως και από άλλες μελέτες

Από τον Γουίλιαμ Τζέιμς έως τη νευροεπιστήμη: Η συνείδηση ίσως απλώς παρακολουθεί τον νου

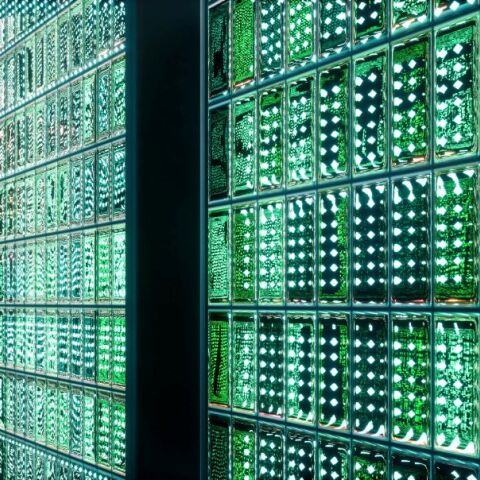

Νέο σύστημα Project Silica γράφει πληροφορίες σε γυαλί με λέιζερ και αντέχει χιλιετίες χωρίς συντήρηση

Η διαδικασία κατάργησης θα συνοδευτεί από σχετική ειδοποίηση εντός της εφαρμογής

Επίσημη έρευνα για πιθανές παραβιάσεις, από παιδικές σεξουαλικές κούκλες έως όπλα και αδιαφανείς αλγορίθμους

Η δημιουργική κοινότητα βρίσκεται αντιμέτωπη με μια πρωτοφανή πρόκληση

Το κόστος, οι προτεραιότητες, οι Κινέζοι

Υπήρχαν αναφορές για προβλήματα πρόσβασης στον ιστότοπο και την εφαρμογή

To μήνυμα που εμφανίζεται στις οθόνες των χρηστών

Απόφοιτος Ιατρικής Σχολής στην Ελλάδα και κάτοχος μεταπτυχιακών τίτλων από τη Γαλλία

Έχετε δει 20 από 200 άρθρα.