- CITY GUIDE

- PODCAST

-

15°

15°

H τεχνητή νοημοσύνη και τα προβλήματά της

Η απόφαση ορόσημο μιας ομοσπονδιακής δικαστίνας στην Αμερική

Ο νέος νόμος πέρι έργων τεχνητής νοημοσύνης και πνευματικών δικαιωμάτων- Τα προβλήματα και οι κίνδυνοι που δημιουργεί η AI

Αν δημιουργήσουμε κάτι με τη βοήθεια της ΤΝ κατέχουμε άραγε τα πνευματικά δικαιώματα της δημιουργίας μας; Μια ομοσπονδιακή δικαστίνα στις ΗΠΑ απεφάνθη πως όχι: η απόφαση της δικαστίνας Beryl Howell επιβεβαίωσε το πόρισμα της Υπηρεσίας Πνευματικών Δικαιωμάτων ότι ένα έργο τέχνης που δημιουργήθηκε με ΤΝ δεν δικαιούται προστασία πνευματικών δικαιωμάτων βάσει του νόμου περί πνευματικής ιδιοκτησίας. Η Howell διευκρινίζει ότι η θεμελιώδης προϋπόθεση για την προστασία των πνευματικών δικαιωμάτων είναι η «ανθρώπινη δημιουργία»· ο νόμος δεν επεκτείνεται σε δημιουργίες μη ανθρώπινων οντοτήτων.

Πρόκειται για μια απόφαση 15 σελίδων αλλά η εφημερίδα ‘’The Hollywood Reporter’’ δημοσίευσε μια διαφωτιστική περίληψη: σύμφωνα με την Αμερικανίδα νομικό, έργα που δημιουργούνται με άλλα τεχνολογικά εργαλεία, όχι με ΤΝ, θα μπορούσαν να προστατεύονται από πνευματικά δικαιώματα —π.χ. φωτογραφίες— πλην όμως, ο νόμος προϋποθέτει σε όλα τα έργα την «ανθρώπινη δημιουργικότητα». Αυτή η δημιουργικότητα βρίσκεται στον πυρήνα της πνευματικής ιδιοκτησίας, ακόμη και όταν ολοκληρώνεται και διοχετεύεται μέσω εργαλείων ή τεχνολογικών μέσων. Στην πραγματικότητα, κάθε ανθρώπινη δημιουργία υλοποιείται με διάφορα εργαλεία: αλλά, αφού ο άνθρωπος αναπτύξει μια «νοητική σύλληψη» π.χ. παίρνοντας καλλιτεχνικές φωτογραφίες ή φτιάχνοντας κινηματογραφικά πλάνα. Αντιθέτως, σύμφωνα με τη Howell, η ΤΝ δημιουργεί από μόνη της ή μιμείται και αντιγράφει ανθρώπινα έργα.

Στο μεταξύ, οι κατασκευαστές εργαλείων τεχνητής νοημοσύνης καλούνται να τσεκάρουν στο Διαδίκτυο το υλικό που προστατεύεται από πνευματικά δικαιώματα χωρίς άδεια ή αποζημίωση για να εκπαιδεύσουν καταλλήλως τα μεγάλα γλωσσικά μοντέλα (LLM) που καθοδηγούν τα chatbot, συμπεριλαμβανομένων των ChatGPT του OpenAi και του Bard της Google. Συγγραφείς και καλλιτέχνες έχουν καταθέσει μηνύσεις κατά των κατασκευαστών chatbot: αυτές οι υποθέσεις περνούν τώρα στα δικαστήρια και θα καταλήξουν στις απαραίτητες νομολογίες.

Οι κίνδυνοι είναι πολλοί. Κατά τη διάρκεια της απεργίας των σεναριογράφων του Χόλιγουντ, τα στούντιο θα μπορούσαν να χρησιμοποιήσουν ΤΝ για τη συγγραφή σεναρίων και τη δημιουργία άλλων έργων που γίνονται σήμερα από συνδικαλισμένους εργαζομένους, προσθέτει το ‘’Hollywood Reporter’’. Kι αυτό παρότι, τον περασμένο Μάρτιο, η Υπηρεσία πνευματικών δικαιωμάτων δήλωσε ότι ορισμένα υλικά που υποστηρίζονται από AI ενδέχεται να πληρούν τις προϋποθέσεις για προστασία πνευματικών δικαιωμάτων σε συγκεκριμένες περιπτώσεις. Η εφαρμογή πνευματικών δικαιωμάτων για ένα έργο που δημιουργήθηκε με τη βοήθεια της τεχνητής νοημοσύνης θα μπορούσε να ισχύει αν ένας άνθρωπος «επέλεξε ή συναρμολόγησε» το έργο με «αρκετά δημιουργικό τρόπο ώστε αυτό που προέκυψε να είναι πρωτότυπο και να φέρει την προσωπική του σφραγίδα». Τι ακριβώς σημαίνει «πρωτότυπο» είναι μακρά συζήτηση: τα συστήματα της generative AI χρησιμοποιούν πληροφορίες από το διαδίκτυο το οποίο είναι γεμάτο σκουπίδια, κλισέ, παρεξηγήσεις και λεπτές αποχρώσεις μεταξύ εννοιών τις οποίες τα ρομπότ δεν μπορούν, προς το παρόν, να αντιληφθούν και να επεξεργαστούν. Εξάλλου, υπάρχει μια ευρεία γκάμα «δημιουργιών» όπως τα deepfakes που είναι έκνομες: η ΤΝ μπορεί να σκαρώσει ψεύτικες φωτογραφίες ατόμων σε ποικίλα περιβάλλοντα, δημιουργώντας fake news ή με σκοπό διάφορες απάτες. Πριν από λίγες εβδομάδες η αστυνομία του Χονγκ Κονγκ συνέλαβε έξι άτομα επειδή χρησιμοποίησαν τεχνολογία deepfake για να αλλάξουν το πρόσωπό τους, ώστε να ξεγελάσουν τις τράπεζες και να κάνουν διαδικτυακή αίτηση για δάνεια, ενώ, όπως θα περίμενε κανείς, ανθεί ήδη η πορνογραφία με deepfakes. Βίντεο κατασκευασμένα με τεχνητή νοημοσύνη προσομοιώνουν σεξουαλικές πράξεις με το πρόσωπο αληθινών γυναικών: σύμφωνα με έκθεση του Bloomberg, τα μη συναινετικά πορνογραφικά deepfakes έχουν εννεαπλασιαστεί από το 2019. Μπροστά σε τέτοιες παρανομίες, το πρόβλημα των πνευματικών δικαιωμάτων φαίνεται δευτερεύον.

Πράγματι, σχεδόν 150.000 βίντεο, με πάνω από 3,8 δισεκατομμύρια προβολές, εμφανίστηκαν σε 30 ιστότοπους τον Μάιο του 2023: ορισμένοι από αυτούς τους ιστοτόπους προσφέρουν βιβλιοθήκες deepfake προγραμματισμού, με πρόσωπα διασημοτήτων κολλημένα σε σώματα πορνοστάρ. Άλλοι προσφέρουν, έναντι κάποιου αντιτίμου, στους πελάτες την ευκαιρία να «γυμνώσουν» γυναίκες που γνωρίζουν, όπως συμμαθήτριες ή συναδέλφους τους. Όπως γνωρίζει όποιος έχει πέσει θύμα deepfake, «κανένας ομοσπονδιακός νόμος δεν ποινικοποιεί επί του παρόντος τη δημιουργία ή την κοινοποίηση μη συναινετικών deepfake πορνό στις ΗΠΑ», προσθέτει το Bloomberg.

Ένα ακόμη πρόβλημα είναι το αν η τεχνητή νοημοσύνη θα γίνει στο μέλλον ένα είδος τυραννικού αφεντικού που θα παρακολουθεί κάθε email των εργαζομένων και θα αποφασίζει ποιος θα απολυθεί. Σύμφωνα με την εφημερίδα Guardian, τα συστήματα τεχνητής νοημοσύνης θα μπορούν, για παράδειγμα, «να διαβάζουν τη ροή των μέσων κοινωνικής δικτύωσης, να ενημερώνονται για τις πολιτικές μας προτιμήσεις και να μας τροφοδοτούν με παραπληροφόρηση για να προσπαθήσουν να μας κάνει, λόγου χάρη, να αλλάξουμε την ψήφο μας.» Το κλειδί για την αντιμετώπιση αυτών των κινδύνων είναι η ενθάρρυνση του σκεπτικισμού και η διασφάλιση της διαφάνειας και της λογοδοσίας, ιδιαίτερα εφόσον ξέρουμε ότι τα chatbot AI είναι επιρρεπή σε χονδροειδή λάθη.

Εκτυλίσσεται συζήτηση σχετικά με το αν τα τρέχοντα συστήματα genAI περνούν το Test Turing, έναν απλό έλεγχο που δημιούργησε ο Βρετανός μαθηματικός Alan Turing για να προσδιοριστεί αν μιλάμε σε άνθρωπο ή σε μηχανή, με βάση μια συναλλαγή βασισμένη σε κείμενο. Ο Turing ονόμασε τη δοκιμή του «παιχνίδι μίμησης». Ορισμένοι ερευνητές λένε ότι το ChatGPT έχει περάσει το τεστ Turing, ότι έχει δηλαδή ανθρώπινη κατανόηση. Άλλοι όμως, λένε ότι δεν περνάει το τεστ: το chatbot δεν μπορεί να «βιώσει» αυτό που μπορούν να βιώσουν οι άνθρωποι. Εν πάση περιπτώσει, μια ομάδα 19 νευροεπιστημόνων, φιλοσόφων και ειδημόνων στους Η/Υ έχει καταλήξει σε μια λίστα ελέγχου κριτηρίων που, αν πληρούνταν, θα έδειχναν ότι ένα σύστημα έχει πολλές πιθανότητες να είναι συνειδητό: αυτό αναφέρει το έγκυρο επιστημονικό περιοδικό Nature. Ο κατάλογός τους περιλαμβάνει τον καθορισμό και τον έλεγχο της συνείδησης χρησιμοποιώντας μια ποικιλία θεωρητικών προσεγγίσεων, αλλά όλα τούτα απέχουν πολύ από το να έχουν ολοκληρωθεί. Η αξιολόγησή τους για το ChatGPT, όπως συνοψίζεται στο Nature, είναι ότι αυτός ο τύπος συστήματος έχει αναμφισβήτητα μερικούς δείκτες συνείδησης αλλά δεν έχει «συνείδηση». Το ίδιο το σύστημα λέει για τον εαυτό του: «Ως μοντέλο γλώσσας τεχνητής νοημοσύνης, βασίζομαι στην τεχνολογία GPT-3 του OpenAI, η οποία είναι ένα ισχυρό εργαλείο για τη δημιουργία κειμένου που μοιάζει με άνθρωπο με βάση τις προτροπές που λαμβάνει. Ενώ το GPT-3 μπορεί να παράγει εντυπωσιακές απαντήσεις και να συμμετάσχει σε συνομιλίες, είναι σημαντικό να σημειωθεί ότι η επιτυχία της δοκιμής Turing συνιστά πιο περίπλοκη αξιολόγηση.»

Πάντως, με λίγα λόγια, σε περίπτωση που εμείς οι χρήστες δεν μπορούμε να διακρίνουμε τη μηχανή από τον άνθρωπο με βάση τις απαντήσεις τους, σημαίνει πως η μηχανή έχει περάσει το τεστ Turing. Στην πραγματικότητα, αν και το GPT-3 μπορεί να δημιουργήσει κείμενο που μπορεί να φαίνεται φτιαγμένο από άνθρωπο, δεν έχει σχεδιαστεί για να περάσει το Τεστ Turing. Η αξιολόγηση του πλήρους φάσματος των ικανοτήτων συνομιλίας που μοιάζουν με τις ανθρώπινες και η επιτυχία στο τεστ Turing απαιτούν την εκπλήρωση αυστηρών κριτηρίων που υπερβαίνουν τις δυνατότητες δημιουργίας κειμένου. Αξίζει να αναφέρουμε ότι το GPT-3 έχει πολλούς περιορισμούς: απόδειξη ότι, κατά καιρούς, δίνει λανθασμένες ή παράλογες απαντήσεις. Ενώ μπορεί να προσφέρει πολύτιμη βοήθεια, είναι σημαντικό να θυμόμαστε ότι είναι μοντέλο τεχνητής νοημοσύνης και όχι άνθρωπος με γνήσια κατανόηση ή συνείδηση.

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Το συνολικό αποτύπωμα της πλατφόρμας είναι περίπου 50 εκατ. μετρικοί τόνοι CO2e

Θέλοντας να τεστάρω τις δυνατότητες και τα όρια του εργαλείου, άρχισα να ζητάω συμβουλές θεωρώντας μάλλον απίθανο (και ηθικά απωθητικό) το να το χρησιμοποιήσω. Μέσα σε μισή ώρα είχα αγοράσει μηνιαία συνδρομή.

Ένα πρωτοποριακό πρόγραμμα για την τεχνολογική εκπαίδευση

Τα τεχνικά προβλήματα όσον αφορά τη σύνδεση και παραμονή στα εν λόγω μέσα κοινωνικής δικτύωσης, παρατηρούνται μάλιστα και στην Ελλάδα.

Το design και οι επιδόσεις του μέλλοντος στο σήμερα

Από τη θεραπεία αυτοάνοσων νοσημάτων με Τ-κύτταρα μέχρι δείγματα χώματος από τη Σελήνη

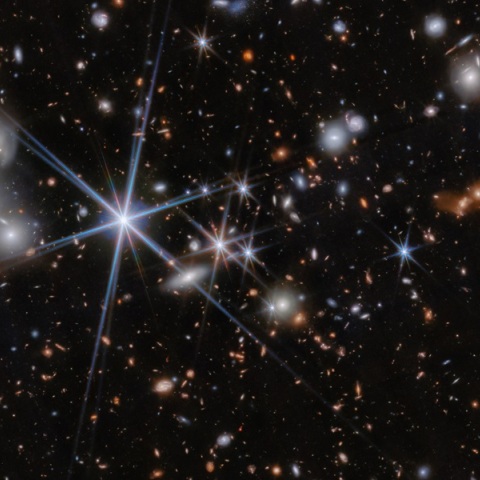

Οι επιστήμονες το 1998 αποκάλυψαν ότι αυτή η διαστολή επιταχύνεται, με την υποτιθέμενη αιτία να είναι η σκοτεινή ενέργεια

Τα αποτελέσματα που ανακοινώθηκαν τη Δευτέρα προήλθαν από ένα νέο τσιπ που ονομάζεται Willow

Πάνω από 15 εκατομμύρια διαδικτυακές απειλές το 2024 - Ανάγκη για ενισχυμένα μέτρα προστασίας

Τα ευρήματα μεγάλης έρευνας

Είναι τόσο μεγάλο κομμάτι της ζωής μας πια, που όταν δεν υπάρχει σύνδεση, κάτι μας πιάνει…

Όψεις της πόλης, αναμνήσεις, πράγματα που συνέβησαν παλιά, και πράγματα που συμβαίνουν σήμερα γύρω μας

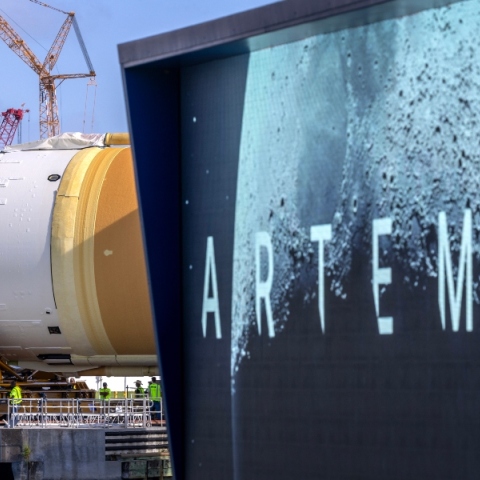

Θα αργήσει η επιστροφή των ΗΠΑ στη Σελήνη

Η υπηρεσία λειτουργεί επί του παρόντος σε μερικές τοποθεσίες στις ΗΠΑ, στο Τέξας και την Αριζόνα

«Τα παιδιά χάνουν τον προσανατολισμό τους, ασχολούνται μόνο με likes»

Διαφορετική εικόνα από εκείνη που επικράτησε στις αγιογραφίες

Πόσο θα επηρεαστεί το οικοσύστημα και το κλίμα της Γης

Σε όλο τον κόσμο γίνονται προσπάθειες για την ανάπτυξη ανθεκτικών καλλιεργειών

Μερικά από τα πιο εμβληματικά και αγαπημένα παιχνίδια πρωταγωνιστούν στο επετειακό clip

Μια επένδυση που ξεπερνά τα 10 δισεκατομμύρια δολάρια

Έχετε δει 20 από 200 άρθρα.