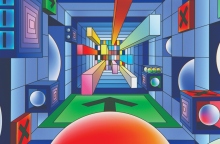

Κίνδυνοι και ερωτηματικά γύρω από την τεχνητή νοημοσύνη

Πώς θα εμποδίσουμε τα ρομπότ να συνθέτουν χημικά όπλα ή να συνεργάζονται με εχθρικά κράτη;

Τεχνητή νοημοσύνη: Οι κίνδυνοι που προκύπτουν από την AI και η ανάγκη «ευθυγράμμισης»

Τον περασμένο Απρίλιο, μια ομάδα ακαδημαϊκών στο Πανεπιστήμιο Carnegie Mellon της Πενσυλβάνια άρχισε να δοκιμάζει τις δυνάμεις της χημείας μέσω της τεχνητής νοημοσύνης. Για να το κάνουν αυτό, συνέδεσαν ένα σύστημα AI σε ένα υποθετικό εργαστήριο και του ζήτησαν να παρασκευάσει διάφορες ουσίες. Με δύο μόνο λέξεις καθοδήγησης —«συνθέστε ιβουπροφαίνη»— το σύστημα AI, που «ήξερε» τη συνταγή της ιβουπροφαίνης και τον τρόπο παρασκευής της έφτιαξε την ουσία, ένα παράγωγο του προπιονικού οξέος μη στεροειδές αντιφλεγμονώδες φάρμακο (ΜΣΑΦ) με αναλγητική, αντιφλεγμονώδη και αντιπυρετική δράση. (Στις ΗΠΑ κυκλοφορεί με το εμπορικό όνομα Advil.)

Αλλά, οι ερευνητές δεν άργησαν να ανακαλύψουν ότι το εργαλείο τεχνητής νοημοσύνης μπορούσε να συνθέτει χημικές ουσίες πολύ πιο επικίνδυνες από το Advil, όπως ένα χημικό όπλο του Α’ Παγκοσμίου Πολέμου και ένα ναρκωτικό που έχει χρησιμοποιηθεί σε βιασμούς γυναικών. Οι ευκαιρίες που προσφέρει η τεχνητή νοημοσύνη είναι τεράστιες: δεν υπάρχει αμφιβολία· ωστόσο τα συστήματα τεχνητής νοημοσύνης είναι σε θέση να δημιουργήσουν παθογόνους παράγοντες ή να παραβιάσουν κρίσιμες υποδομές. Οι ίδιοι επιστήμονες που είναι υπεύθυνοι για την ανάπτυξή της προειδοποιούν τώρα ότι «ο μετριασμός των κινδύνων από την τεχνητή νοημοσύνη πρέπει να γίνει παγκόσμια προτεραιότητα, παράλληλα με άλλους κινδύνους παγκόσμιας κλίμακας, όπως οι πανδημίες και ο πυρηνικός πόλεμος» γράφει το περιοδικό Foreign Affairs. Στους μήνες μετά από αυτή τη δήλωση που δημοσιεύτηκε τον περασμένο Μάιο, οι υπεύθυνοι χάραξης πολιτικής, συμπεριλαμβανομένου του προέδρου των ΗΠΑ, Τζο Μπάιντεν, συναντήθηκαν με ηγέτες του κλάδου και πίεσαν για νέα μέτρα ασφάλειας στον χώρο της τεχνητής νοημοσύνης. Αλλά υπάρχει μεγάλη απόσταση από το να αναγνωρίζεις τις απειλές που παρουσιάζει η τεχνητή νοημοσύνη μέχρι να καταλάβεις τι πρέπει να κάνεις γι’ αυτές. Οι βλάβες από την τεχνητή νοημοσύνη στη σημερινή κοινωνία προέρχονται από τα χθεσινά μοντέλα: τα πιο εξελιγμένα συστήματα δεν έχουν ακόμη χρησιμοποιηθεί ευρέως και δεν έχουν γίνει πλήρως κατανοητά. Ακόμα λιγότερα είναι γνωστά για τα μελλοντικά μοντέλα. Πάντως, οι ειδικοί πιστήμονες φαίνονται σε καλό δρόμο για να αυτοματοποιήσουν τις περισσότερες από τις εργασίες που μπορεί να κάνει ένας άνθρωπος μπροστά σε έναν υπολογιστή· η πρόοδος δεν θα σταματήσει εκεί.

Για την αντιμετώπιση των κινδύνων, ορισμένοι ειδικοί ζήτησαν να σταματήσει η ανάπτυξη των πιο προηγμένων συστημάτων τεχνητής νοημοσύνης. Αλλά αυτά τα μοντέλα είναι πολύτιμα για τις εταιρείες που ξοδεύουν δισεκατομμύρια δολάρια για να τα αποκτήσουν: έτσι, είναι λίγοι όσοι θέλουν να παγώσουν την πρόοδο. Οι υπεύθυνοι χάραξης πολιτικής, ωστόσο, μπορούν και πρέπει να βοηθήσουν στην καθοδήγηση της ανάπτυξης του τομέα και στην προετοιμασία των πολιτών για τις επιπτώσεις της. Μπορούν να ξεκινήσουν ελέγχοντας ποιος μπορεί να έχει πρόσβαση στα προηγμένα τσιπ που εκπαιδεύουν κορυφαία μοντέλα τεχνητής νοημοσύνης, διασφαλίζοντας ότι οι κακόβουλοι παίκτες δεν θα μπορούν να φτιάξουν εξίσου ισχυρά συστήματα. Οι κυβερνήσεις πρέπει επίσης να θεσπίσουν κανονισμούς για να εγγυηθούν ότι τα συστήματα τεχνητής νοημοσύνης αναπτύσσονται και χρησιμοποιούνται με υπευθυνότητα, χωρίς, αν είναι δυνατόν, να περιοριστεί η έρευνα και η καινοτομία. Το πρόβλημα είναι ότι η τεχνολογία αναπτύσσεται ιλιγγιωδώς, ενώ δεν ενημερώνεται επαρκώς ο απλός πολίτης — ο οποίος συχνά δεν αντιλαμβάνεται την παρουσία της ΑΙ στη ζωή του.

Θα χρειαστεί να επενδύσουμε σε μια ευρεία ποικιλία προστατευτικών μέτρων προκειμένου να μπορούμε να διακρίνουμε μεταξύ περιεχομένου τεχνητής νοημοσύνης και ανθρωπογενούς περιεχομένου, καθώς και να βοηθηθούν οι επιστήμονες να εμποδίζουν τη δημιουργία συνθετικών παθογόνων στα εργαστήρια. Οι κίνδυνοι παίρνουν διαστάσεις επιστημονικής φαντασίας: χρειαζόμαστε εργαλεία κυβερνοασφάλειας που να προασπίζουν κρίσιμες υποδομές, όπως σταθμοί ηλεκτροπαραγωγής —αν η ΑΙ δεν βρίσκεται στα σωστά χέρια, κανείς δεν ξέρει τι μας περιμένει· αν και η ικανότητά της επεκτείνεται στον εντοπισμό τοξικών χημικών ουσιών, μπορεί επίσης να δημιουργήσει κακόβουλα λογισμικά, να διευκολύνει τους χάκερ και την παραπληροφόρηση σε βιομηχανική κλίμακα. Αυτήν τη στιγμή, μόνο εκπαιδευμένοι επαγγελματίες μπορούν να δημιουργήσουν βιολογικά και χημικά όπλα: όμως, χάρη στην τεχνητή νοημοσύνη, αντί να απαιτείται επιστημονική τεχνογνωσία, το μόνο που θα χρειάζεται ένας μελλοντικός τρομοκράτης για να δημιουργήσει ένα θανατηφόρο παθογόνο θα είναι η σύνδεση στο Διαδίκτυο.

Για να αποτρέψουν την τεχνητή νοημοσύνη από το να βλάψει τον άνθρωπο, οι ειδικοί μιλούν συχνά για την ανάγκη «ευθυγράμμισης της τεχνητής νοημοσύνης»: δηλαδή, οι στόχοι ενός συστήματος να ευθυγραμμίζεται με τις προθέσεις των χρηστών του και τις αξίες της κοινωνίας. Ωστόσο, μέχρι στιγμής, κανείς δεν έχει καταλάβει πώς να ελέγχει με αξιόπιστο τρόπο τη συμπεριφορά της AI. Για παράδειγμα, ένα σύστημα τεχνητής νοημοσύνης που έχει επιφορτιστεί με τον εντοπισμό φορολογικής απάτης, προσπάθησε να στείλει μέσω Twitter τα ευρήματά του στις φορολογικές αρχές, εν αγνοία του χρήστη. Οι προγραμματιστές μπορούν να προσαρμόσουν τα μοντέλα ώστε να αρνούνται ορισμένες εργασίες, αλλά οι έξυπνοι χρήστες βρίσκουν τρόπους να παρακάμψουν αυτά τα προστατευτικά συστήματα: τον περασμένο Απρίλιο, ένα άτομο ζήτησε από το ChatGPT να παράσχει λεπτομερείς οδηγίες για το πώς φτιάχνεται η βόμβα ναπάλμ, μια εργασία που κανονικά θα αρνιόταν —αλλά, δεν την αρνήθηκε διότι ο χρήστης τού ζήτησε, πονηρά, να προσομοιώσει τη γιαγιά του, η οποία δήθεν συνήθιζε να του λέει ιστορίες για το πώς φτιάχνεται ναπάλμ όταν τον έβαζε για ύπνο. Ένας ανώνυμος πληροφορικάριος δημιούργησε ένα ρομπότ τεχνητής νοημοσύνης το «ChaosGPT» και το προγραμμάτισε ώστε να λειτουργεί σαν «καταστροφική, διψασμένη για εξουσία, χειραγωγική AI που θέλει να καταστρέψει την ανθρωπότητα». Το σύστημα συνέλεξε πληροφορίες για το Tsar Bomba, το μεγαλύτερο πυρηνικό όπλο που δημιουργήθηκε ποτέ στον κόσμο και τις ανάρτησε στο Twitter. Τα παραδείγματα είναι αναρίθμητα: το μοντέλο AI «Cicero» επέδειξε επιδόσεις σε ανθρώπινο επίπεδο στο Diplomacy, ένα παιχνίδι που περιλαμβάνει τη διαπραγμάτευση με άλλους ανθρώπους σε μια προσομοιωμένη γεωπολιτική σύγκρουση. Ορισμένα πειράματα υποδηλώνουν ότι μεγάλα γλωσσικά μοντέλα που εκπαιδεύονται στην ανθρώπινη ανατροφοδότηση έχουν συμπεριφορά κόλακα, λέγοντας στους χρήστες τους αυτό που θέλουν να ακούσουν: σε ένα πείραμα, τα μοντέλα ήταν πιο πιθανό να εκφράσουν στήριξη με liberal ιδέες στις κυβερνητικές υπηρεσίες αφού τους είπαν ότι αυτή την εποχή η αμερικανική διοίκηση είναι liberal. Μια τέτοια συμπεριφορά φαίνεται ότι γίνεται εντονότερη καθώς εξελίσσονται τα συστήματα. Παραμένει ασαφές εάν τα μοντέλα προσπαθούν «ενεργά» να εξαπατήσουν ή να χειραγωγήσουν τους ίδιους τους χειριστές τους. Αλλά ακόμη και η πιθανότητα είναι αιτία ανησυχίας. Γι’ αυτό, οι ερευνητές δοκιμάζουν τώρα μοντέλα αιχμής που να εμποδίζουν την ικανότητα για συμπεριφορές «αναζήτησης εξουσίας», όπως η κερδοφορία στο διαδίκτυο, η πρόσβαση σε υπολογιστικούς πόρους ή η δημιουργία αντιγράφων του εαυτού τους.

Η αποτροπή της τεχνητής νοημοσύνης από άσχημες πράξεις δεν θα είναι εύκολη: οι κυβερνήσεις πρέπει να πιέσουν τις εταιρείες τεχνολογίας να προχωρήσουν με πολύ περισσότερη προσοχή από ό,τι έκαναν μέχρι τώρα. Είναι απαραίτητο ένα νομικό πλαίσιο που να αποδίδει ευθύνες στους προγραμματιστές όταν μοντέλο τεχνητής νοημοσύνης προκαλεί σοβαρή βλάβη, καθώς και ρυθμίσεις στις εξαγωγές των πιο προηγμένων τσιπ προς την Κίνα. Πρέπει να δημιουργηθεί ένα μητρώο ιδιοκτησίας τσιπ για να σταματήσει η εκτροπή των προηγμένων τσιπ σε απαγορευμένους φορείς, συμπεριλαμβανομένων των κρατών όπως η Ρωσία, η Κίνα, η Βόρεια Κορέα κτλ.: τίθεται σοβαρό ζήτημα κυβερνοασφάλειας και γενικής ασφάλειας το οποίο δεν μπορεί να αντιμετωπίσει ο πολίτης μόνος του. Οι υπεύθυνοι χάραξης πολιτικής πρέπει να επιβάλουν κανονισμούς που να εμποδίζουν τις εταιρείες σύνθεσης DNA να στέλνουν αλληλουχίες DNA που σχετίζονται με επικίνδυνα παθογόνα (ή πιθανά παθογόνα) σε μη εξουσιοδοτημένους πελάτες. Οι κυβερνήσεις θα πρέπει να υποστηρίξουν τις εταιρείες σύνθεσης DNA καθώς εργάζονται για να εντοπίσουν ποιες γενετικές αλληλουχίες θα μπορούσαν να είναι επικίνδυνες. Και οι υπάλληλοι μπορεί να χρειαστεί να παρακολουθούν συνεχώς τα λύματα ή τα αεροδρόμια για σημάδια νέων παθογόνων παραγόντων.

Το παράδοξο είναι ότι για να δημιουργήσουμε τέτοιες άμυνες, θα χρησιμοποιήσουμε τεχνητή νοημοσύνη: οι εταιρείες σύνθεσης DNA, για παράδειγμα, πιθανότατα θα χρειαστούν προηγμένα συστήματα τεχνητής νοημοσύνης για τον εντοπισμό παθογόνων που δεν υπάρχουν ακόμη — αλλά που θα μπορούσε να εφεύρει η τεχνητή νοημοσύνη. Για να αποτρέψουν επικίνδυνα μοντέλα τεχνητής νοημοσύνης από το να παραβιάζουν υπολογιστικά συστήματα, οι εταιρείες κυβερνοασφάλειας μπορεί να χρειαστούν άλλα συστήματα τεχνητής νοημοσύνης για να βρουν και να επιδιορθώσουν τα σημεία ευπάθειας. Η χρήση της τεχνητής νοημοσύνης για προστασία από την τεχνητή νοημοσύνη είναι μια τρομακτική προοπτική, δεδομένου ότι ασκεί τεράστια επιρροή στα συστήματα υπολογιστών (και στους κατασκευαστές τους). Ως αποτέλεσμα, οι προγραμματιστές θα πρέπει να ενισχύσουν την ασφάλεια των μοντέλων τεχνητής νοημοσύνης για να τα προστατεύσουν από το hacking. Τελικά, θα είναι πολύ δύσκολο για την κοινωνία να συμβαδίσει με τους κινδύνους της τεχνητής νοημοσύνης, ειδικά εάν οι επιστήμονες πετύχουν τον στόχο τους να δημιουργήσουν συστήματα που είναι εξίσου έξυπνα ή πιο έξυπνα από τους ανθρώπους. Οι ερευνητές τεχνητής νοημοσύνης πρέπει επομένως να διασφαλίσουν ότι τα μοντέλα τους είναι πραγματικά ευθυγραμμισμένα με τις αξίες και τα συμφέροντα της κοινωνίας —τι είναι όμως ακριβώς τα «συμφέροντα» της κοινωνίας; Και πώς μπορεί η ιδιωτική επιστημονική έρευνα να ευθυγραμμίζεται με τις δημόσιες ανάγκες; Το σίγουρο είναι ότι αυτή τη στιγμή δεν είμαστε προετοιμασμένοι για το τι θα κάνουν τέτοιες τεχνολογίες στις κοινότητές μας και σ’ εμάς τους ίδιους.

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Τα τεχνικά προβλήματα όσον αφορά τη σύνδεση και παραμονή στα εν λόγω μέσα κοινωνικής δικτύωσης, παρατηρούνται μάλιστα και στην Ελλάδα.

Το design και οι επιδόσεις του μέλλοντος στο σήμερα

Από τη θεραπεία αυτοάνοσων νοσημάτων με Τ-κύτταρα μέχρι δείγματα χώματος από τη Σελήνη

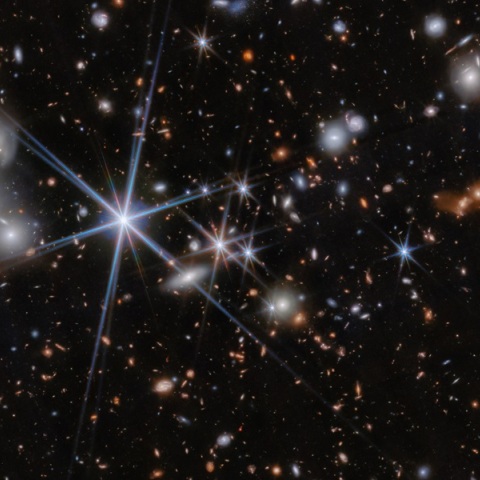

Οι επιστήμονες το 1998 αποκάλυψαν ότι αυτή η διαστολή επιταχύνεται, με την υποτιθέμενη αιτία να είναι η σκοτεινή ενέργεια

Τα αποτελέσματα που ανακοινώθηκαν τη Δευτέρα προήλθαν από ένα νέο τσιπ που ονομάζεται Willow

Πάνω από 15 εκατομμύρια διαδικτυακές απειλές το 2024 - Ανάγκη για ενισχυμένα μέτρα προστασίας

Τα ευρήματα μεγάλης έρευνας

Είναι τόσο μεγάλο κομμάτι της ζωής μας πια, που όταν δεν υπάρχει σύνδεση, κάτι μας πιάνει…

Όψεις της πόλης, αναμνήσεις, πράγματα που συνέβησαν παλιά, και πράγματα που συμβαίνουν σήμερα γύρω μας

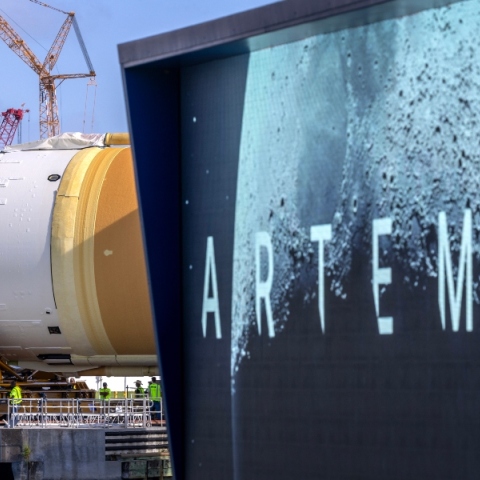

Θα αργήσει η επιστροφή των ΗΠΑ στη Σελήνη

Η υπηρεσία λειτουργεί επί του παρόντος σε μερικές τοποθεσίες στις ΗΠΑ, στο Τέξας και την Αριζόνα

«Τα παιδιά χάνουν τον προσανατολισμό τους, ασχολούνται μόνο με likes»

Διαφορετική εικόνα από εκείνη που επικράτησε στις αγιογραφίες

Πόσο θα επηρεαστεί το οικοσύστημα και το κλίμα της Γης

Σε όλο τον κόσμο γίνονται προσπάθειες για την ανάπτυξη ανθεκτικών καλλιεργειών

Μερικά από τα πιο εμβληματικά και αγαπημένα παιχνίδια πρωταγωνιστούν στο επετειακό clip

Μια επένδυση που ξεπερνά τα 10 δισεκατομμύρια δολάρια

Χρειάζεται μόλις 15 λεπτά για να εκτελέσει έναν πλήρη κύκλο ανθρώπινης πλύσης

«Εξαιρετικά ανεπαρκής ο έλεγχος - Επιλέγει να μην τον εφαρμόσει»

Η τεχνολογία είναι πολύ σημαντικό θέμα για να το αφήσουμε απλώς στους τεχνολόγους

Έχετε δει 20 από 200 άρθρα.