Πώς ο MrBeast και δύο παρουσιαστές του BBC χρησιμοποιήθηκαν σε deepfake βίντεο

Το χρονικό της απάτης με τα «δωρεάν» iPhones και τη «συνέντευξη» του Elon Musk

Ο μεγαλύτερος YouTuber στον κόσμο, ο MrBeast και δύο παρουσιαστές του BBC χρησιμοποιήθηκαν σε deepfake βίντεο για να εξαπατήσουν ανυποψίαστους χρήστες στο διαδίκτυο

Τα deepfake βίντεο χρησιμοποιούν τεχνητή νοημοσύνη για τη δημιουργία ψεύτικων βίντεο με πρωταγωνιστές celebrities, χωρίς φυσικά την συγκατάθεσή τους. Ένα τέτοιο βίντεο εμφανίστηκε στο TikTok αυτή την εβδομάδα, υποστηρίζοντας ότι ο MrBeast σκοπεύει να δωρίσει καινούργια iPhone για 2 μόλις δολάρια το καθένα σε χιλιάδες τυχερούς.

Τα deepafake βίντεο με τους τηλεπαρουσιαστές του BBC

Εν τω μεταξύ, deepfake βίντεο με δύο διάσημους τηλεοπτικούς παρουσιαστές του BBC, του Matthew Amroliwala και της Sally Bundock, χρησιμοποιήθηκαν για την προώθηση μιας επενδυτικής απάτης. Τα βίντεο που κυκλοφόρησαν στο Facebook έδειχναν τους δημοσιογράφους να παρουσιάζουν τον «Elon Musk», τον δισεκατομμυριούχο ιδιοκτήτη του X, που υποτίθεται ότι απευθυνόταν σε βρετανούς καταναλωτές, δίνοντάς τους την ευκαιρία να κερδίσουν μέχρι και 5.700 λίρες την ημέρα.

Παρόμοια deepfake βίντεο έχουν κυκλοφορήσει στο παρελθόν δείχνοντας έναν ψεύτικο Elon Musk να μοιράζει χρήματα και κρυπτονομίσματα. Συνήθως τέτοια βίντεο εντοπίζονται πολύ γρήγορα και «κατεβαίνουν» από το διαδίκτυο, αλλά για τον λίγο χρόνο που προλαβαίνουν να κυκλοφορήσουν, κάνουν αρκετή ζημιά.

Όπως περιγράφει η παρουσιάστρια του BBC, Sally Bundock, ήταν μία συνηθισμένη Δευτέρα όταν ο σύζυγός της έλαβε μια κλήση από έναν φίλο: «“Sally, πήρες συνέντευξη από τον Elon Musk τελευταία;” “ Όχι... Μακάρι”, ήταν η απάντησή μου. Εκείνη τη στιγμή συνειδητοποίησα ότι είχα πιαστεί κορόιδο. Ένα ψεύτικο βίντεο με εμένα, στο στούντιο του BBC News, να παρουσιάζω μια έκτακτη επιχειρηματική είδηση κυκλοφορούσε στα μέσα κοινωνικής δικτύωσης. Έπαθα σοκ. Σε αυτόν τον κόσμο που ζούμε, αναρωτήθηκα, ήταν απλώς θέμα χρόνου; Μόλις συνήλθα ακολούθησαν οι ερωτήσεις. Και τώρα τι κάνω; Αυτό το ψεύτικο βίντεο, που δημιουργήθηκε με χρήση ΑΙ, παραπλανεί τους θεατές σε μια οικονομική απάτη. Ισχυρίζεται, χρησιμοποιώντας μια ψεύτικη εικόνα μου, ότι οι βρετανοί μέσω ενός νέου επενδυτικού σχεδίου που δημιουργήθηκε από τον Elon Musk, μπορούν να αποκομίσουν σημαντικά κέρδη - τόσα πολλά που θα μπορούσαν να παραιτηθούν από τις δουλειές τους. Ακούγεται πολύ καλό για να είναι αληθινό και αυτό είναι το κλειδί. Έτσι μπορείς να εντοπίσεις την απάτη».

Το BBC προσέγγισε τη Meta, ιδιοκτήτρια εταιρία του Facebook και τα επίμαχα βίντεο αφαιρέθηκαν από τότε. «Δεν επιτρέπουμε τέτοιου είδους περιεχόμενο στις πλατφόρμες μας και τα έχουμε αφαιρέσει», δήλωσε εκπρόσωπος της Meta. «Εργαζόμαστε συνεχώς για να βελτιώσουμε τα συστήματά μας και να ενθαρρύνουμε όποιον βλέπει περιεχόμενο που πιστεύει ότι παραβαίνει τους κανόνες μας να το αναφέρει χρησιμοποιώντας τα εργαλεία εντός της εφαρμογής μας, ώστε να μπορέσουμε να το διερευνήσουμε και να αναλάβουμε δράση».

Προηγουμένως, τα ψεύτικα βίντεο με τους δύο παρουσιαστές του βρετανικού καναλιού συνοδεύονταν από ένα εικονίδιο που προειδοποιούσε τους θεατές ότι περιείχαν ψευδείς πληροφορίες ελεγμένες από τους ανεξάρτητους ελεγκτές δεδομένων FullFact, οι οποίοι ανέφεραν το πρόβλημα. Όπως δήλωσαν στον ιστότοπό τους, τα ψεύτικα βίντεο περιλάμβαναν λογότυπα και λεζάντες που ήταν διαφορετικά από τα επίσημα αντίστοιχα του BBC, άλλη μια ένδειξη ότι δεν ήταν γνήσια.

Ο ιστότοπος FullFact που έχει ως σκοπό να ελέγχει ψευδείς ειδήσεις στο διαδίκτυο (σαν το δικό μας Ellinika Hoaxes), έχει εκθέσει στο παρελθόν παρόμοια βίντεο με πρωταγωνιστές τον Τζούλιαν Ασάνζ, τον Πάπα Φραντσίσκο, τον Ντόναλντ Τραμπ, τον πρόεδρο της Γαλλίας Μακρόν, καθώς και τους πρίγκιπες της Αγγλίας Χάρι και Γουίλιαμ. Αυτοί ήταν που πρώτοι εντόπισαν την απάτη.

Εν τω μεταξύ, ένας εκπρόσωπος του TikTok δήλωσε ότι η εταιρεία αφαίρεσε το βίντεο με τον MrBeast μέσα σε λίγες ώρες από την εμφάνισή του και ο λογαριασμός που το δημοσίευσε καταργήθηκε λόγω παραβίασης των κανονισμών του. Το TikTok απαγορεύει συγκεκριμένα «την χρήση τεχνητών ή συνθετικών μέσων που περιέχουν ομοιότητες (οπτικές ή ηχητικές) με ένα πραγματικό πρόσωπο».

Σε μια ανάρτηση στο X που προβλήθηκε περισσότερες από 28 εκατομμύρια φορές, ο YouTuber μοιράστηκε το ψεύτικο βίντεο και απευθύνθηκε στις πλατφόρμες κοινωνικών μέσων ρωτώντας αν ήταν ικανές να χειριστούν την άνοδο των deepfakes.

Lots of people are getting this deepfake scam ad of me… are social media platforms ready to handle the rise of AI deepfakes? This is a serious problem pic.twitter.com/llkhxswQSw

— MrBeast (@MrBeast) October 3, 2023

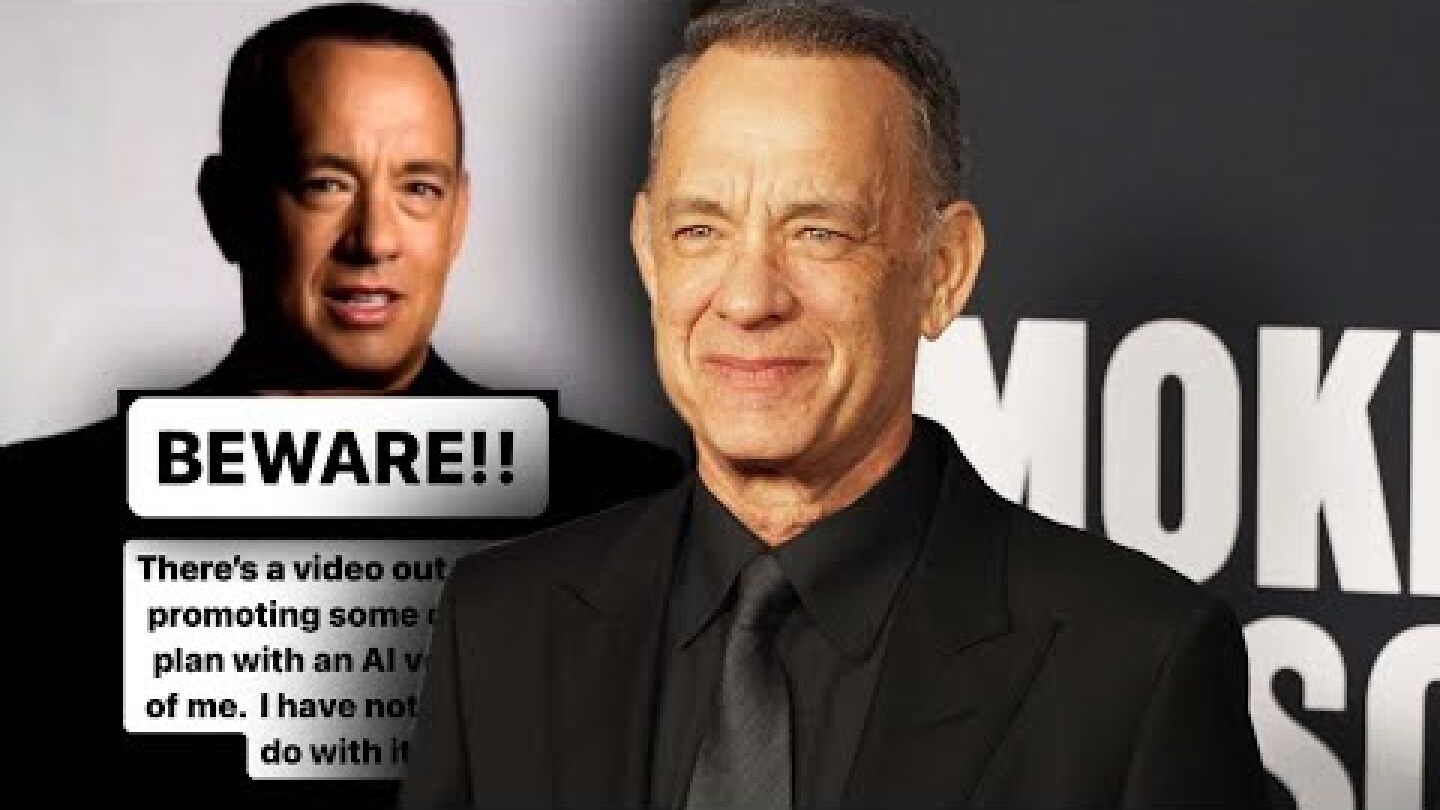

Εκτός από τον MrBeast, υπήρξαν και άλλα deepfakes υψηλού προφίλ τις τελευταίες εβδομάδες, με τον Τομ Χανκς να προειδοποιεί τη Δευτέρα ότι μια αγγελία που εμφανιζόταν μπροστά από τον ίδιο, προωθώντας ασφάλειες υγείας δεν ήταν πραγματικό.

Πώς να εντοπίσετε ένα deepfake βίντεο

Καθώς η τεχνολογία της τεχνητής νοημοσύνης αναπτύσσεται συνεχώς, τόσο αυξάνονται οι ανησυχίες σχετικά με την ικανότητά της να δημιουργεί όλο και πιο ρεαλιστικές εικονικές απεικονίσεις πραγματικών ανθρώπων. Σε γενικές γραμμές, η πρώτη ένδειξη ότι ένα βίντεο μπορεί να μην είναι αυτό που φαίνεται, είναι ότι προσφέρει κάτι πολύ καλό για να είναι αληθινό. Αλλά, το βίντεο του MrBeast αποτελεί εξαίρεση σε αυτόν τον κανόνα.

Ο YouTuber έχει χτίσει το όνομά του χαρίζοντας αυτοκίνητα, σπίτια και μετρητά. Και δεν είναι η πρώτη φορά που μοιράζει iPhone, όπως έκανε πέρυσι στο Halloween, οπότε είναι εύκολο να καταλάβουμε πώς ο κόσμος πίστεψε ότι πραγματικά δώριζε αυτές τις συσκευές στο διαδίκτυο.

Όσοι όμως είναι εξοικειωμένοι με την τεχνολογία και δώσουν λίγο παραπάνω προσοχή, μπορούν να εντοπίσουν τα σημάδια ότι κάτι δεν πάει καλά. Οι απατεώνες προσπάθησαν να φτιάξουν ένα πειστικό βίντεο ενσωματώνοντας το όνομα του MrBeast στην κάτω αριστερή γωνία του βίντεο, καθώς και το μπλε σήμα επαλήθευσης που χρησιμοποιείται σε πολλές διαφορετικές πλατφόρμες μέσων κοινωνικής δικτύωσης. Αλλά, τα TikTok βίντεο ενσωματώνουν αυτόματα το πραγματικό όνομα του χρήστη κάτω από το ίδιο το λογότυπο του TikTok.

Εν τω μεταξύ, στα βίντεο με τους δύο παρουσιαστές του BBC, τα λάθη είναι πιο έντονα. Για παράδειγμα, στο βίντεο της Sally Bundock, η «παρουσιάστρια» προφέρει λανθασμένα το «fifteen» ως «fife-teen», ενώ προφέρει περίεργα το «project» ως «pro-ject». Λέει επίσης ότι «επενδύθηκε» περισσότερα από 3 δισεκατομμύρια δολάρια στο νέο έργο, αντί για «επενδύθηκαν».

Αυτά τα λάθη μπορεί να είναι αμελητέα, αλλά καθώς η τεχνολογία προχωρά και η οπτική απεικόνιση γίνεται όλο και πιο ρεαλιστική, τα λεκτικά λάθη - όπως τα ορθογραφικά λάθη που συναντάμε σε ένα ηλεκτρονικό μήνυμα απάτης- μπορεί να είναι ένας καλός τρόπος για να διαπιστώσετε εάν ένα βίντεο είναι ψεύτικο.

Σύμφωνα με μια μελέτη του 2018, Αμερικανοί ερευνητές από το πανεπιστήμιο του Cornell της Νέας Υόρκης, ανακάλυψαν ότι τα deepfake πρόσωπα δεν ανοιγοκλείνουν τα μάτια τους κανονικά. Αυτό εξηγείται, καθώς οι περισσότερες φωτογραφίες ανθρώπων τους δείχνουν με τα μάτια ανοιχτά. Έτσι, οι αλγόριθμοι δεν μαθαίνουν ποτέ πραγματικά να μιμούνται το ανοιγοκλείσιμο των ματιών. Στην αρχή φάνηκε ότι αυτό θα μπορούσε να είναι το αδύναμο σημείο των deepfake βίντεο. Αλλά, μόλις δημοσιεύθηκε η έρευνα, αμέσως εμφανίστηκαν τα πρώτα deepfakes που είχαν βελτιώσει τον αλγόριθμό τους.

Ο συγχρονισμός των χειλιών μπορεί επίσης να είναι κακός ή η απόχρωση του δέρματος να «βγάζει μάτι». Κάποια pixels μπορεί να είναι εκτός θέσης, ενώ λεπτομέρειες, όπως τα μαλλιά, είναι ιδιαίτερα δύσκολο να αποδοθούν σωστά. Τα κοσμήματα και τα δόντια μπορούν επίσης να προδώσουν ένα deepfake βίντεο, όπως και ο περίεργος φωτισμός ή οι αντανακλάσεις στην ίριδα του ματιού, καθώς και η «ρομποτική» ομιλία.

Στο βίντεο με τον παρουσιαστή του BBC, Matthew Amroliwana, υπάρχουν κάποιες ηχητικές παραμορφώσεις, με μπερδεμένους ήχους στην αρχή ορισμένων προτάσεων. Υπάρχουν πολλές ενδείξεις σε αυτό το βίντεο ότι τα πράγματα δεν είναι όπως φαίνονται. Το κείμενο είναι διαφορετικό από αυτό που χρησιμοποιεί το BBC News, με ορθογραφικά λάθη και περίεργες φράσεις. Αλλά, υπάρχει τουλάχιστον ένα ξεκάθαρο οπτικό λάθος που προδίδει το βίντεο, όταν ένα τρίτο μάτι εμφανίζεται στιγμιαία στο μέτωπο του «Elon Musk». Αυτός ο τύπος σφάλματος, γνωστό και ως glitch είναι συνηθισμένος στα deepfakes, αν και πολύ σύντομα θα βρεθεί τρόπος να εξαλειφθεί και αυτό.

Τι λέει ο νόμος για τα deepfakes;

Όσον αφορά στη νομοθεσία, εκεί τα πράγματα γίνονται αρκετά περίπλοκα, επειδή οι νόμοι είναι διαφορετικοί σε κάθε χώρα, δήλωσε η ειδικός στο Δίκαιο του Διαδικτύου από το Πανεπιστήμιο του Νιούκαστλ, Lilian Edwards στο BBC. «Ποιος νόμος εφαρμόζεται σε περιπτώσεις παραβίασης πνευματικών δικαιωμάτων αυτού του είδους, όταν μια αμερικανική εταιρεία για παράδειγμα, εξαπατήσει έναν βρετανό πολίτη χρησιμοποιώντας μια κινεζική πλατφόρμα», αναρωτήθηκε.

«Θα μπορούσατε ενδεχομένως να χρησιμοποιήσετε νόμους περί δυσφήμισης ή νόμους περί προστασίας δεδομένων, όπου η φωνή ή η εικόνα σας χρησιμοποιείται χωρίς την άδειά σας και χωρίς καλή αιτία», συμβούλευσε η Edwards. Αλλά, προειδοποίησε ότι θα ήταν κακή ιδέα να ποινικοποιηθούν όλα τα deepfakes. «Αν αρχίσετε να ποινικοποιείτε την παραγωγή οποιουδήποτε deepfake, ποινικοποιείτε τη βιομηχανία των ειδικών εφέ στις ταινίες», είπε. «Ποινικοποιείς μεγάλο μέρος της τέχνης που παράγουν οι άνθρωποι και στο τέλος κάνεις τα πράγματα χειρότερα».

Πρόσφατο παράδειγμα αποτελεί το τελευταίο βίντεο κλιπ των ΑΒΒΑ, όπου με την χρήση ΑΙ κατάφεραν να δημιουργήσουν μια virtual συναυλία, με τα τέσσερα μέλη της μπάντας να απεικονίζονται σε νεότερες εκδοχές τους.

Τα deepfake βίντεο ήρθαν για να μείνουν

Κατά ένα ειρωνικό τρόπο, η ίδια η τεχνητή νοημοσύνη μπορεί να είναι η λύση. Η ΑΙ χρησιμοποιείται ήδη στον εντοπισμό ψεύτικων βίντεο, αλλά η υπάρχουσα τεχνολογία έχει για την ώρα μια σοβαρή αδυναμία. Λειτουργεί καλύτερα σε celebrities, επειδή μπορεί να εκπαιδευτεί σε ένα τεράστιο όγκο από διαθέσιμα βίντεο. Αν ο οποιοσδήποτε από εμάς πέσει θύμα τέτοιου βίντεο, θα είναι πολύ δύσκολο να ανιχνευτεί η απάτη.

«Το πρόβλημα μπορεί να μην είναι τόσο η ψεύτικη πραγματικότητα, όσο το γεγονός ότι η πραγματική πραγματικότητα γίνεται αμφισβητήσιμη», δήλωσε στην Guadian η Lilian Edwards.

Καθώς η τεχνολογία γίνεται πιο εύκολη στον χειρισμό και πιο φθηνή, τα deepfakes θα μπορούσαν να προκαλέσουν προβλήματα στα δικαστήρια, όπου πλαστά στοιχεία θα μπορούσαν να καταχωρηθούν ως αποδεικτικά. Θέτουν επίσης πολλούς κίνδυνους ασφάλειας. Τα deepfakes μπορούν να μιμηθούν βιομετρικά δεδομένα και μπορούν να ξεγελάσουν συστήματα που βασίζονται στην αναγνώριση προσώπου ή φωνής. Οι ευκαιρίες για απάτες είναι ατελείωτες και δυστυχώς, τα deepfake βίντεο ήρθαν για να μείνουν και καλώς ή κακώς θα πρέπει να μάθουμε να ζούμε με αυτά.

Όσο τα εργαλεία τεχνητής νοημοσύνης γίνονται όλο και πιο προσιτά, τόσο αυτά τα βίντεο θα πληθαίνουν. Και το μεγαλύτερο ίσως πρόβλημα που θα δημιουργήσουν τα deepfakes, σε συνδυασμό με τα fake news, είναι η δημιουργία μιας κοινωνίας απαξίωσης και μηδενικής εμπιστοσύνης, όπου οι άνθρωποι δεν θα μπορούν ή δεν θα μπαίνουν καν στον κόπο να ξεχωρίσουν την αλήθεια από το ψέμα.

ΤΑ ΠΙΟ ΔΗΜΟΦΙΛΗ

ΔΙΑΒΑΖΟΝΤΑΙ ΠΑΝΤΑ

ΔΕΙΤΕ ΕΠΙΣΗΣ

Η Μπέσσυ Μάλφα αποκάλυψε επίσης πως ήταν η πρώτη φωνή στο σήμα του MEGA!

Το σχόλιο της τραγουδίστριας

Η τοποθέτηση του ηθοποιού για την κριτική της Πόπης Διαμαντάκου στον Χριστόφορο Παπακαλιάτη

Πάλι βασίζεται σε αληθινή ιστορία – Οι συντελεστές και το σενάριο

Η στιγμή του σεισμού στο Χαλάνδρι την ώρα της συνέντευξης της Ηλιάνας Μαυρομάτη

Το σχόλιo της πρωταγωνίστριας του Maestro

Τι είπε για την ζωή στην χώρα μας

Η δημοσιογράφος μίλησε για το σοβαρό πρόβλημα υγείας που αντιμετώπισε ενώ ήταν έγκυος

«Όλα πολύ καλά για το Maestro, αλλά είχε ένα μεγάλο ελάττωμα...»

Τι δήλωσε η πρώην σύζυγος του μεγάλου ερμηνευτή

Δεν είναι στενάχωρο οι άνθρωποι που ήταν φίλοι να μην είναι;

«Δε μπορώ να ακούω να λένε ένα βρεφάκι χοντρό. Bullying και στα μωρά;», συμπλήρωσε η τραγουδίστρια

«Αγαπώ την πατρίδα μου και τα παιδιά μου», ανέφερε ο ηθοποιός

Η νεότερη ανάρτησή της αναφορικά με την εγκυμοσύνη της

«Δεν έκανα εγώ το λάθος. Εγώ το διόρθωσα» - Η συγκλονιστική ατάκα του Καπετάν Δεκάξι

Η χιουμοριστική ανάρτηση στο Instagram

«Μιλάει για κάτι που είναι πολύ δύσκολο πια»

Έχετε δει 20 από 200 άρθρα.